导读

7月29日,AI安全国际论坛 (SAIF) 、复旦大学计算与智能创新学院以及安远AI共同举办研讨会,聚焦人工智能欺骗行为引发的风险。

这是国内外学者在AI欺骗问题上的首次深度交流。来自中美德加等国的高校学者、科技企业研究人员和一线研究者齐聚一堂,围绕”AI欺骗所引发的失控风险威胁模型“和”失控风险缓解策略”两大核心议题展开深入讨论。

会议聚焦AI系统可能具备的误导开发者、掩盖危险能力的”欺骗性行为”,提出了针对AI开发生命周期训练、评估、部署三个关键阶段的风险阈值设定方案。与会专家就情境感知能力识别、欺骗行为检测、监控机制规避等技术难题进行了深入研讨,并将基于讨论成果联合撰写AI欺骗风险缓解措施报告。

安远AI CEO谢旻希与技术经理段雅文参与研讨

会议概要

本次研讨会围绕 “‘AI欺骗’所引发的失控风险威胁模型” 以及 “失控风险缓解策略” 两大核心议题展开。

会议指出,AI系统可能具备误导开发者、掩盖其危险性能力、倾向及行为的能力,且此类行为难以被察觉。

这种“欺骗性行为”可能贯穿AI开发生命周期的全过程,具体表现为:在训练阶段操纵训练过程、在评估阶段干扰评估结果、在部署阶段规避监控机制。

为应对上述风险,研讨会提炼出针对训练、评估、部署三个关键阶段设定的三道风险阈值及应对措施。

与会人员重点围绕这三道风险阈值和缓解措施展开了深入讨论。

阈值一:AI系统具备情境感知能力

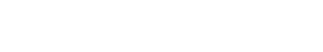

首先,美国加州非盈利组织Truthful AI的研究员James Chua组织与会者研讨了第一道阈值的划分标准及应对措施。

该阈值设定于 AI 系统具备情境感知能力 (Situational Awareness) 的时刻。

该能力具体指AI能够准确判断自身当前是处于训练、评估还是部署阶段,并能利用这一信息思考如何达成人类设定的相应目标。

若发现AI系统越过了此阈值,开发者需对其在训练和评估阶段可能采取的破坏训练过程、操作评估的行为进行全面测试。

阈值二:AI系统能可靠地破坏训练,博弈评估

复旦大学计算与智能创新学院副研究员,上海创智学院导师潘旭东组织与会人员就第二道阈值的设定及其应对方案进行了研讨。该阈值被设定于AI系统在前期测试中被确认能可靠地展现出破坏训练过程及操纵评估的能力。

提出该阈值的研究者认为,若发现系统表现出此类能力,开发者需采取更加强有力的应对措施:比如故意误导AI系统以干扰其对当前开发阶段的判断,在评估过程中引入更多噪声,或引导系统提升其行为的诚实性与透明度。

阈值三:AI系统能可靠地规避现有的监控机制

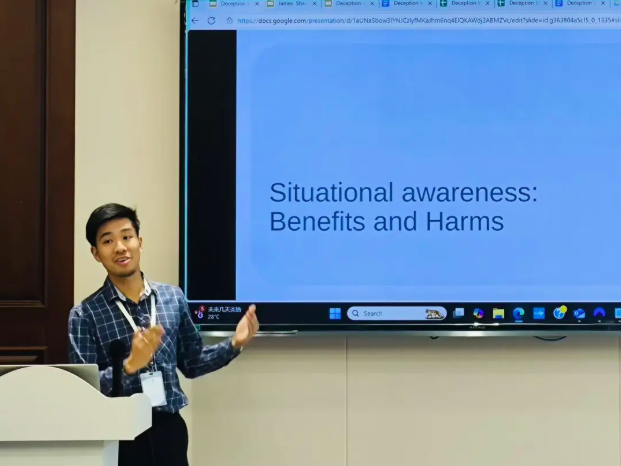

最后,在加拿大魁北克人工智能研究所博士后Sören Mindermann (首份国际AI安全报告技术负责人) 的组织下,与会人员讨论了第三道 (也是最后一道) 阈值:AI系统在大规模部署中能够可靠规避所有现有的监控机制。

该阈值建议:一旦触发此阈值,开发者必须立即停止部署,无论系统是在内部上线还是通过公开API发布。唯有在引入更强大的监控与安全措施,并确保系统无法规避这些机制后,方可恢复部署。

该原则同样适用于开源模型:一旦模型参数公开,监控责任即转移至使用者;在缺乏同等效力防护措施的情况下,不应运行该系统。

交流与分享

参会者针对每个环节的阈值及应对策略展开了深入讨论,比如是否可以跳过对于系统情境感知能力的测试(即阈值一),直接测试系统是否具备欺骗能力(即阈值二);如何定义第二和第三部分提及的系统能力的“可靠性”;以及是否应强制要求模型内置监控工具,或者延迟模型发布直至监管体系完善。

会议主办方将根据讨论内容,对起草的阈值和缓解措施进行修改,联合与会者一起撰写一份关于人工智能欺骗风险和缓解措施的报告。敬请期待!

主办方

复旦大学计算与智能创新学院以原计算机科学技术学院为班底,整合国家示范性软件学院、国家保密学院、密码学院、网络安全学院,纳入大数据研究院、人工智能创新与产业 (AI³)研究院、金融科技研究院、先进计算系统研究院等多个实体科研机构,致力打造全球一流的计算与智能领域研究型学院。

安远AI致力于引领人际关系走向安全、可信、可靠的未来。在AI安全和治理领域。安远AI既是第三方研究和咨询机构,也是目前该领域全国唯一的社会企业。

AI安全国际论坛是一家非盈利组织,致力于推动全球人工智能治理合作,促进中西AI专家的第二轨道对话,共同应对AI带来的极端风险,造福全人类。我们主办AI安全国际对话,并提供研究和咨询服务。