导言

2025年4月26日,《新加坡共识:全球人工智能安全研究优先事项》在新加坡人工智能会议:人工智能安全国际科学交流会(Singapore Conference on AI, SCAI) 上正式发布。由全球顶尖学术机构的100多位专家共同制定,明确提出了风险评估、安全开发和可控性三大研究优先领域,旨在通过国际协作共建AI安全技术框架。

继2023年首次新加坡人工智能会议后,安远AI第二次受邀出席并参与了《新加坡共识》初稿的反馈和建议工作。安远AI期待《新加坡共识》能成为加速推进全球AI安全行动的重要契机,共同构建更加安全、可靠的人工智能生态体系。

4月26日,第二届新加坡人工智能会议:人工智能安全国际科学交流会顺利举办。会议吸引了麻省理工学院、斯坦福大学、清华大学和中国科学院等学术机构的专家,以及来自OpenAI、Anthropic、Google DeepMind、xAI和Meta等科技公司的研究人员参与。会议同时促成了《新加坡共识:全球人工智能安全研究优先事项》的发布。

大会项目委员会汇聚了全球顶尖学者,包括加州大学伯克利分校的Dawn Song教授和Stuart Russell教授、清华大学的薛澜教授和张亚勤教授、南洋理工大学的Luke Ong教授、麻省理工学院及未来生命研究所的Max Tegmark教授、蒙特利尔大学Mila研究院的Tegan Maharaj博士和Yoshua Bengio教授。

安远AI CEO谢旻希与国际AI治理主管吴君仪受邀出席了本次会议,并积极参与了《新加坡共识》初稿的反馈和建议工作。继2023年12月首次受邀参与后,安远AI再次受邀出席。

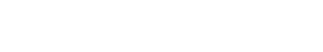

《新加坡共识》由全球100多位顶尖专家共同推动,是识别通用型先进人工智能系统潜在风险、推动技术解决方案的重要里程碑,呼吁全球研究者围绕以下三大关键领域展开深入协作:

- 风险评估:旨在理解潜在危害的严重性和发生可能性,为关键研发和部署决策提供基础。研究方向包括开发衡量AI系统影响的方法,提升计量学能力确保测量结果的准确性和可重复性,以及构建支持第三方审计的机制,实现独立验证。

- 安全开发:致力于从设计层面确保AI系统值得信赖、可靠且安全,增强人们对AI创新的信心。遵循经典安全工程框架,研究方向包括明确AI系统的目标行为规范,设计符合规范的系统,以及验证系统是否满足要求。

- 可控性:通过反馈调节系统行为,确保AI在面对干扰或不确定性时仍能实现预期目标。研究方向包括开发监测与干预机制,拓展监测范围至更广泛的AI生态系统,以及增强社会基础设施适应AI带来的变革,提升整体社会韧性。

清华大学文科资深教授薛澜在评价这一共识时表示:”在当前地缘政治日益碎片化的背景下,这份关于AI安全前沿研究的全面汇总,体现了全球社会在构建更安全AI未来方面的共同承诺。“

安远AI在2024年更新发布的《中国人工智能安全全景报告》也显示,中国研究人员正积极贡献全球AI安全科学研究和治理体系构建。AI安全是各国面临的共同挑战和机遇,安远AI期待《新加坡共识》能成为加速推进全球AI安全行动的重要契机,共同构建更加安全、可靠的人工智能生态体系。

点击链接,查看完整共识文件。